首页 > Python资料 博客日记

【个人开发】llama2部署实践(三)——python部署llama服务(基于GPU加速)

2024-06-02 23:00:07Python资料围观299次

1.python环境准备

注:llama-cpp-python安装一定要带上前面的参数安装,如果仅用pip install装,启动服务时并没将模型加载到GPU里面。

# CMAKE_ARGS="-DLLAMA_METAL=on" FORCE_CMAKE=1 pip install llama-cpp-python

CMAKE_ARGS="-DLLAMA_CUBLAS=on" FORCE_CMAKE=1 pip install llama-cpp-python

pip install uvicorn

pip install starlette

pip install fastapi

pip install sse_starlette

pip install starlette_context

pip install pydantic_settings

2.llama-cpp-python安装报错

报错踩坑1:

安装llama-cpp-python过程出现报错

CMake Error at vendor/llama.Cpp/CMakeLists.txt:186 (find library):

Could not find FOUNDATION LIBRARY using the followingnames: Foundation

解决方法1:

网上找到采用离线安装到方式,可以成功安装,但是高兴得太早了。

wget https://github.com/abetlen/llama-cpp-python/releases/download/v0.2.56/llama_cpp_python-0.2.56-cp311-cp311-manylinux_2_17_x86_64.whl

pip install llama_cpp_python-0.2.56-cp311-cp311-manylinux_2_17_x86_64.whl

# 参考链接:https://blog.csdn.net/qq_38463737/article/details/136477026

坑1:

虽然可以成功安装,但是启动llama服务的时候,没法用到GPU加速。

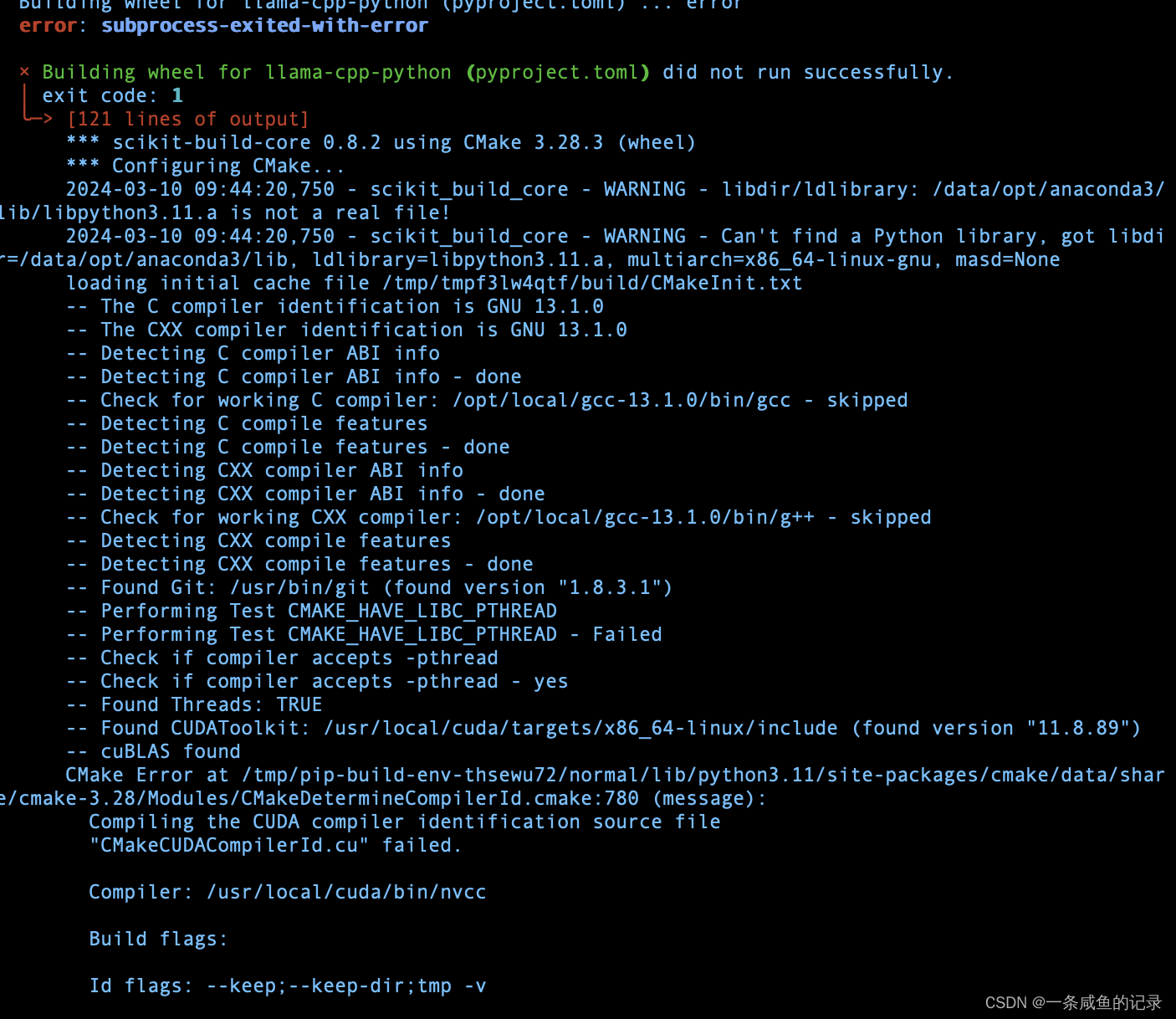

报错踩坑2:

倒腾了很久,看报错一直是cmake对问题,寻思着可能是gcc版本的问题,将gcc升级到13.1。但还是出现报错:

CMake Error at vendor/llama.Cpp/CMakeLists.txt:186 (find library):

Could not find FOUNDATION LIBRARY using the followingnames: Foundation

或者其他诸如的报错【报错太多,没法全记录下来】

CMake configuration failed

看上面的报错Compiling the CUDA compiler identification source file “CMakeCUDACompilerId.cu” failed。感觉像是cuda跟gcc版本的不兼容问题。

解决方法2:

捣鼓了很久,后来参考了一些成功安装的经验,最后选择gcc-9.4.0版本

附带一下gcc版本安装步骤:

## 安装

tar xf gcc-9.4.0.tar.xz

cd gcc-9.4.0/

./contrib/download_prerequisites

mkdir build && cd build

../configure --prefix=/usr/local/gcc-9.4.0 --enable-bootstrap --enable-checking=release --enable-languages=c,c++ --disable-multilib

make -j16 # 我这里服务器是16核,这里根据服务器核数修改并行度。

make install

## 配置环境变量

export GCC_ME_HOME=/usr/local/gcc-9.4.0/

PATH=$GCC_ME_HOME/bin:/usr/local/bin:$PATH

export PATH

LD_LIBRARY_PATH=$GCC_ME_HOME/lib:$GCC_ME_HOME/lib64:/usr/local/lib:/usr/local/lib64:/usr/lib64:/lib64:$LD_LIBRARY_PATH

export LD_LIBRARY_PATH

export CC=$GCC_ME_HOME/bin/gcc

export CXX=$GCC_ME_HOME/bin/g++

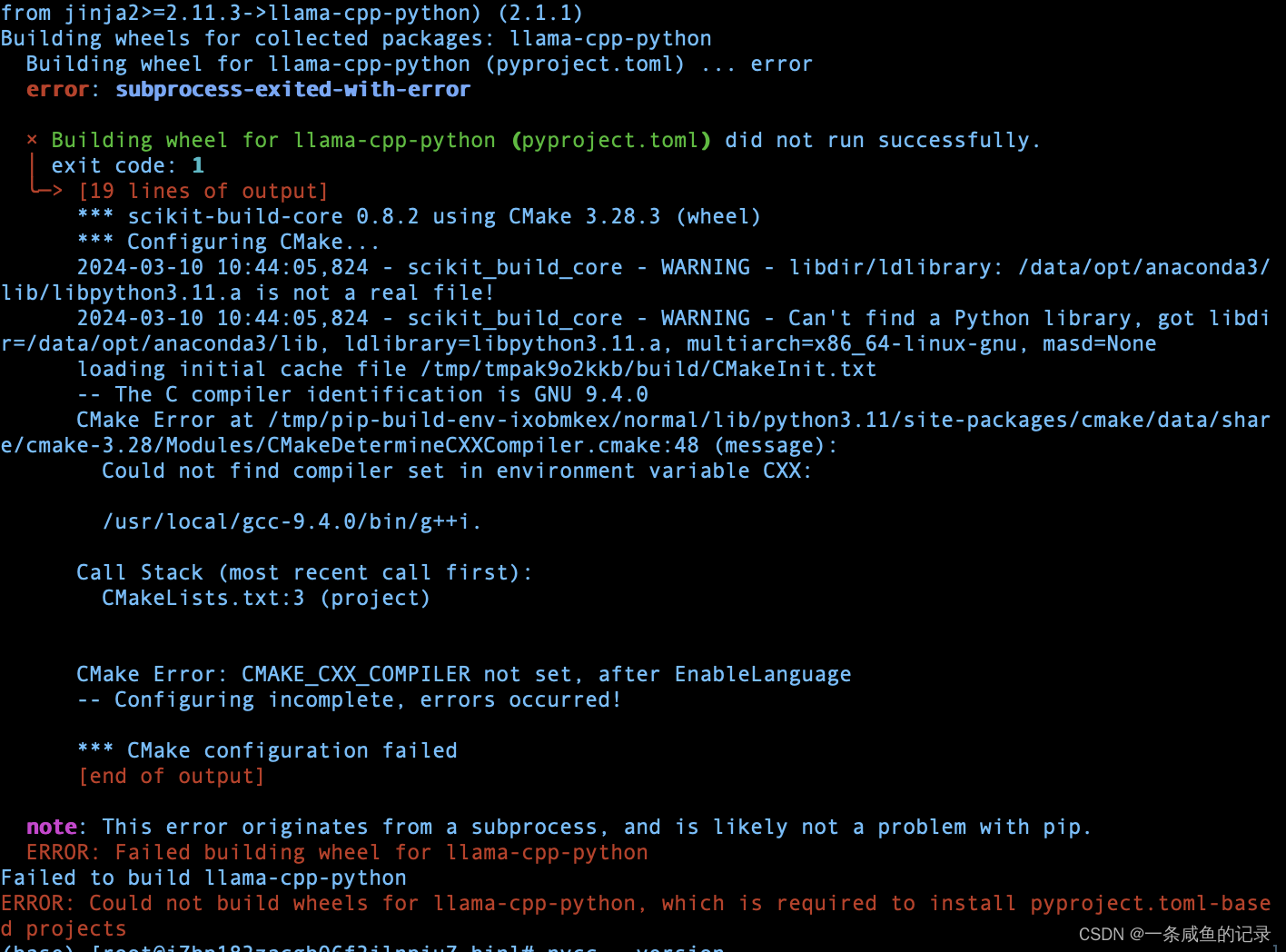

报错踩坑2:

后来还遇到这个问题

Could not find compiler set in environment variable CXX:

估摸着应该是CXX变量没加载的原因,重新加载环境变量,安装。

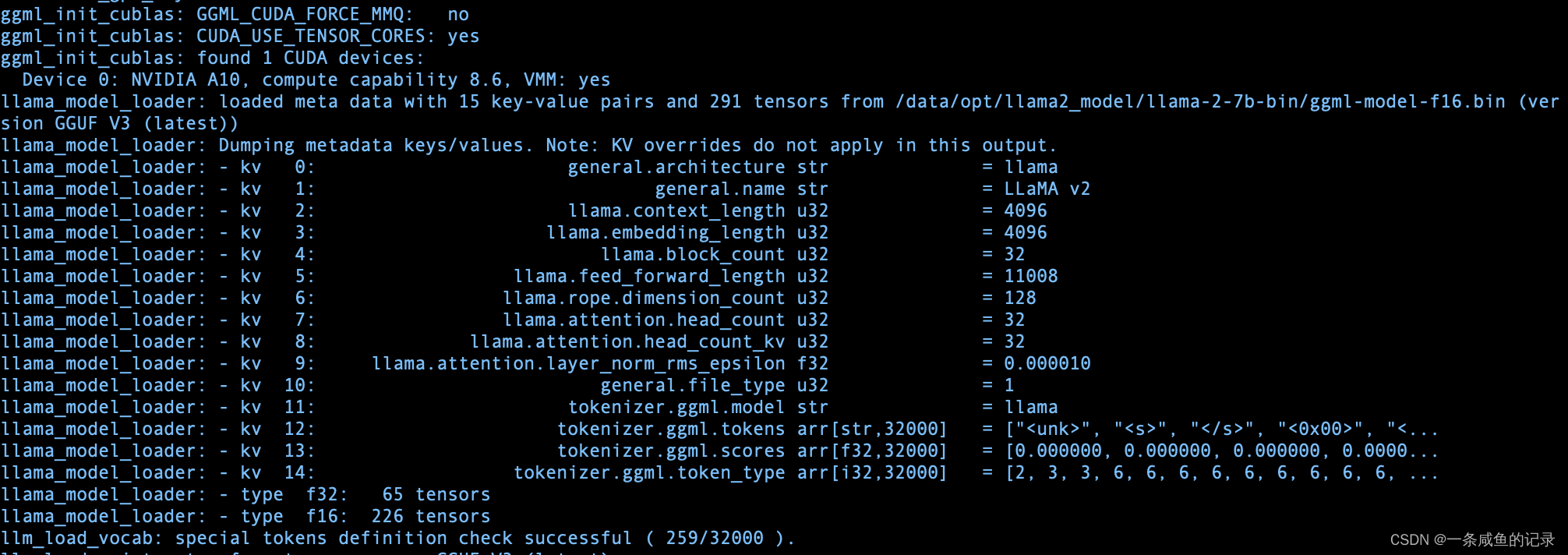

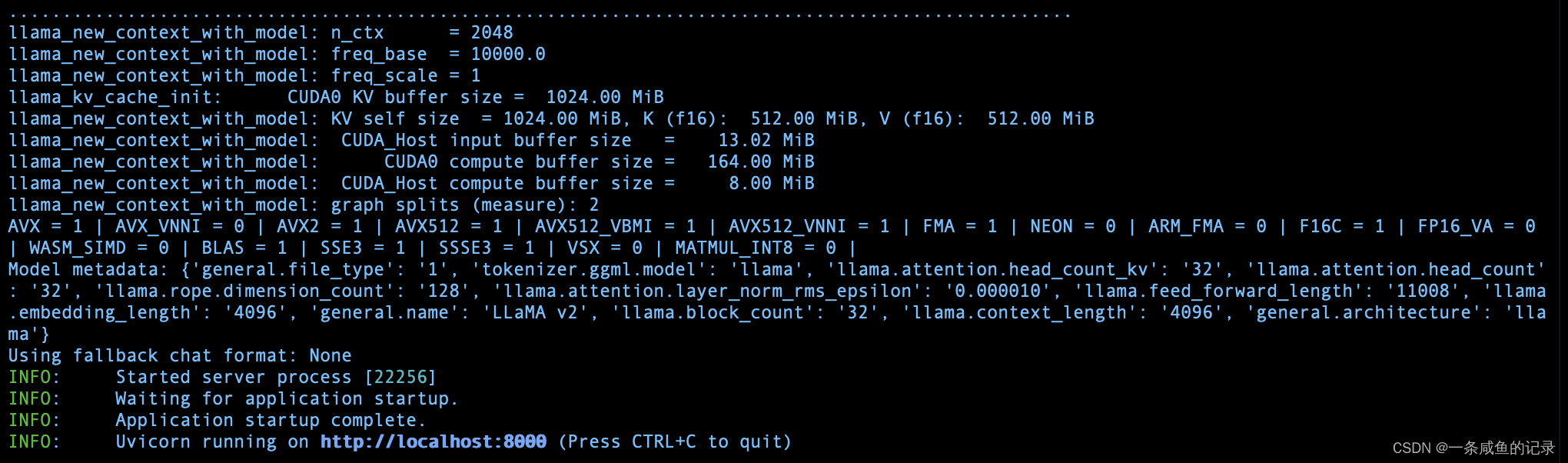

3.服务启动

python3 -m llama_cpp.server --model /data/opt/llama2_model/llama-2-7b-bin/ggml-model-f16.bin --n_threads 30 --n_gpu_layers 200

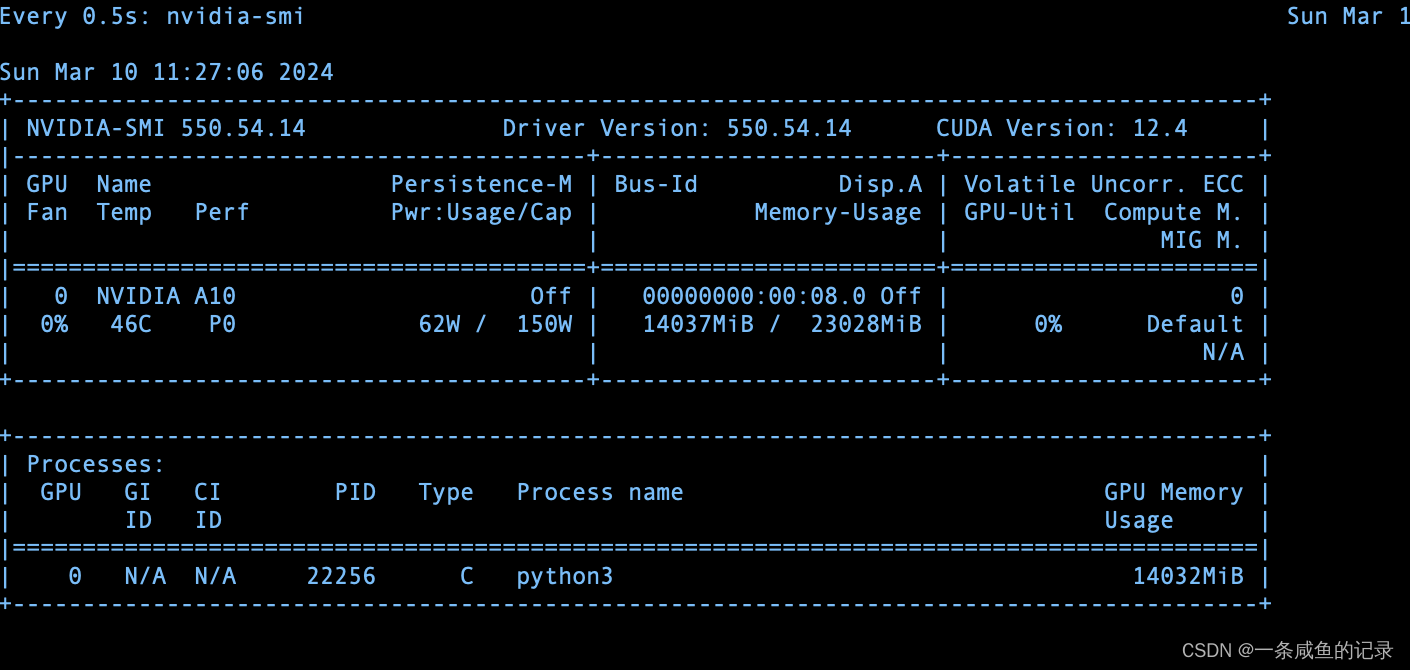

终于加载到GPU里面!

4.总结

当前环境各组件版本:

- gcc:9.4.0

- cuda:11.8

- python:3.11.4

- llama_cpp_python:0.2.56

以上,End

标签:

相关文章

最新发布

- 光流法结合深度学习神经网络的原理及应用(完整代码都有Python opencv)

- Python 图像处理进阶:特征提取与图像分类

- 大数据可视化分析-基于python的电影数据分析及可视化系统_9532dr50

- 【Python】入门(运算、输出、数据类型)

- 【Python】第一弹---解锁编程新世界:深入理解计算机基础与Python入门指南

- 华为OD机试E卷 --第k个排列 --24年OD统一考试(Java & JS & Python & C & C++)

- Python已安装包在import时报错未找到的解决方法

- 【Python】自动化神器PyAutoGUI —告别手动操作,一键模拟鼠标键盘,玩转微信及各种软件自动化

- Pycharm连接SQL Sever(详细教程)

- Python编程练习题及解析(49题)

点击排行

- 版本匹配指南:Numpy版本和Python版本的对应关系

- 版本匹配指南:PyTorch版本、torchvision 版本和Python版本的对应关系

- Python 可视化 web 神器:streamlit、Gradio、dash、nicegui;低代码 Python Web 框架:PyWebIO

- 相关性分析——Pearson相关系数+热力图(附data和Python完整代码)

- Anaconda版本和Python版本对应关系(持续更新...)

- Python与PyTorch的版本对应

- Windows上安装 Python 环境并配置环境变量 (超详细教程)

- Python pyinstaller打包exe最完整教程