首页 > Python资料 博客日记

Python|flash_attn 安装方法

2024-09-10 11:00:26Python资料围观559次

本篇文章分享Python|flash_attn 安装方法,对你有帮助的话记得收藏一下,看Python资料网收获更多编程知识

Step 1|打开 flash_attn 的 Github 项目的 releases 页面

flash-attn的 pypi 地址:https://pypi.org/project/flash-attn/

直接使用 pypi 安装会安装最新版本,不一定适配本地环境,所以需要直接从 release 中选择合适的版本安装。官方包只有 Linux 系统,Windows 系统可以使用大佬编译的包:

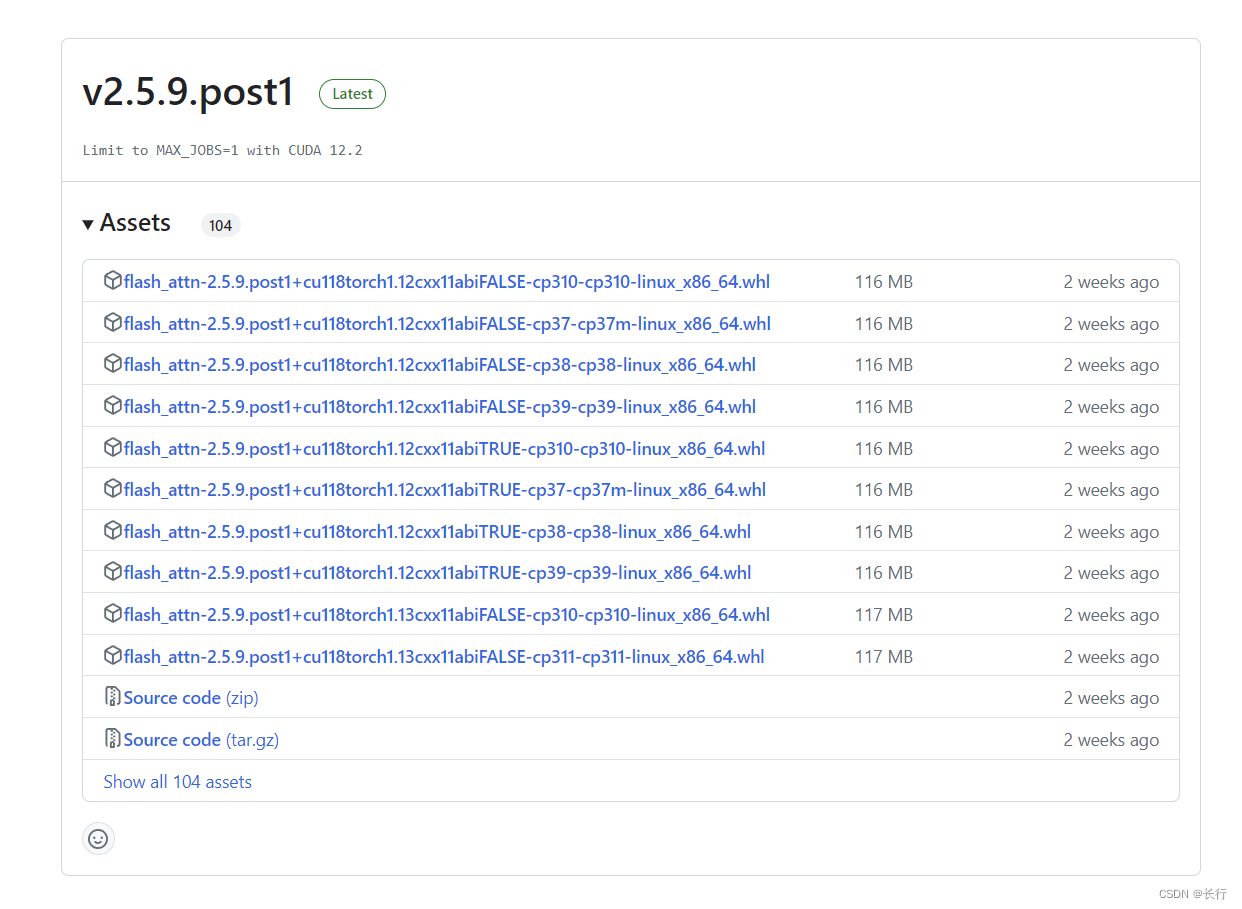

- Linux 系统 whl 文件下载地址:https://github.com/Dao-AILab/flash-attention/releases

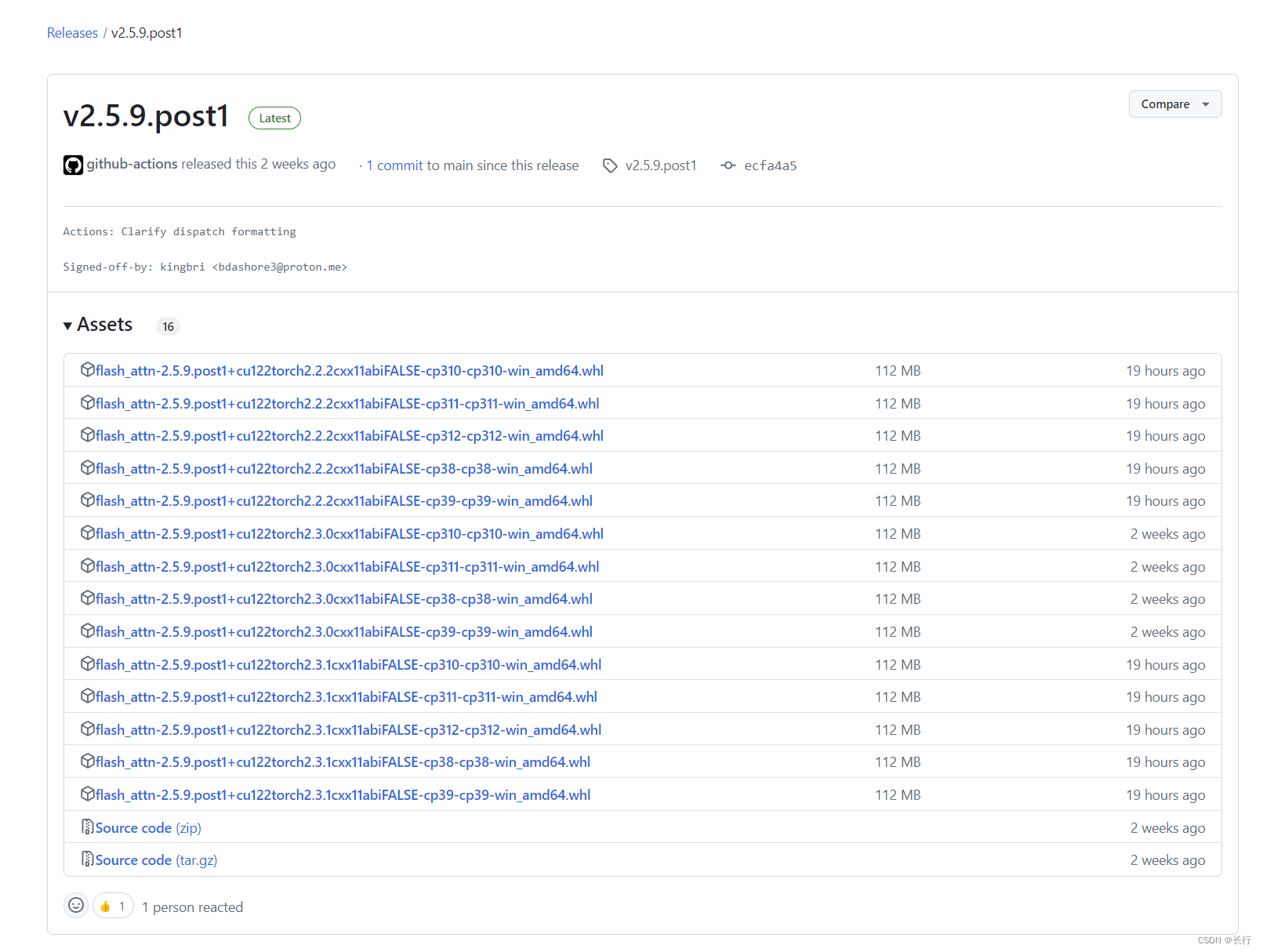

- Window 系统 whl 文件下载地址:https://github.com/bdashore3/flash-attention/releases(非官方)

Step 2|选择适合的版本并下载

在 flash_attn 的版本上,直接选择最新版本即可(若最新版本的 flash_attn 没有适合的 CUDA 版本和 pytorch 版本则应用更早的版本)。

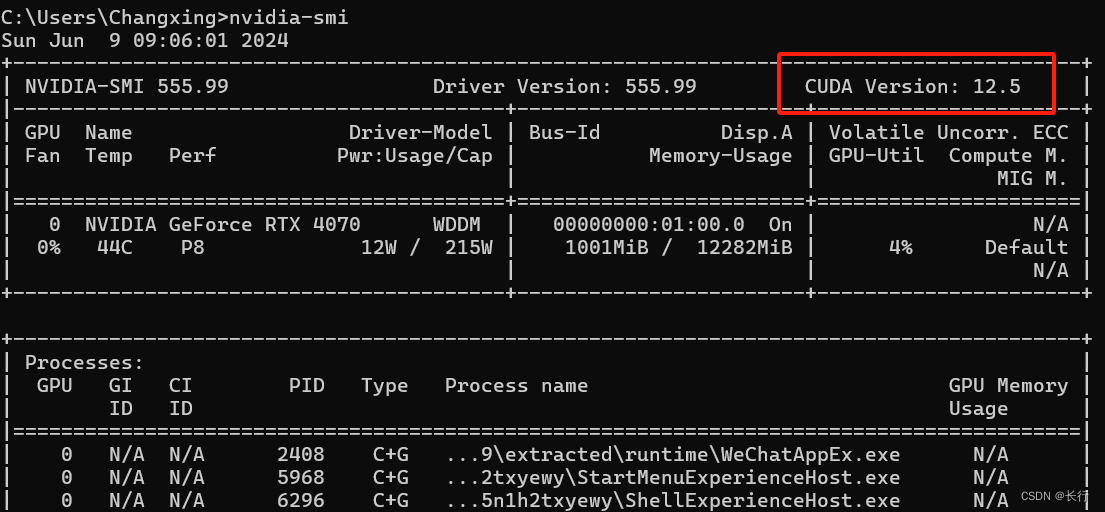

- 版本文件名中的第一部分(例如

cu118、cu122)为 CUDA 版本。本地 CUDA 版本可以通过nvidia-smi命令查看:

- 版本文件名中的第二部分(例如

torch2.1、torch2.2、torch2.3)为 pytorch 版本,选择本地 pytorch 对应的版本即可。本地 pytorch 版本可以通过pip show torch命令查看:

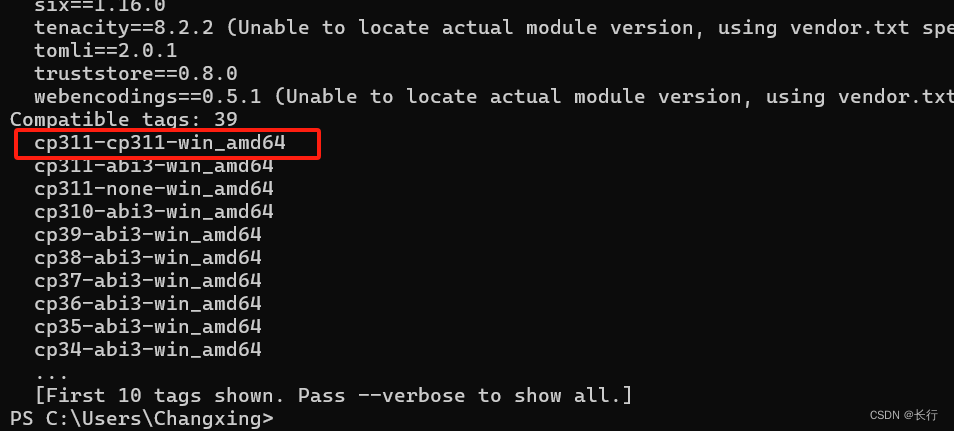

- 版本文件名的第三部分(例如

cp311-cp311-win_amd64)为 Python 版本,选择本地 Python 版本即可。本地 Python 版本可以通过pip debug命令查看:

Step 3|安装 flash_attn 模块

进入下载路径,pip 安装即可:

pip install flash_attn-2.5.9.post1+cu122torch2.3.1cxx11abiFALSE-cp311-cp311-win_amd64.whl

参考文档:https://blog.csdn.net/2301_77818837/article/details/135642828

如果尝试直接编译 whl 文件的话,可能遇到的问题如下:

版权声明:本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若内容造成侵权/违法违规/事实不符,请联系邮箱:jacktools123@163.com进行投诉反馈,一经查实,立即删除!

标签:

相关文章

最新发布

- 光流法结合深度学习神经网络的原理及应用(完整代码都有Python opencv)

- Python 图像处理进阶:特征提取与图像分类

- 大数据可视化分析-基于python的电影数据分析及可视化系统_9532dr50

- 【Python】入门(运算、输出、数据类型)

- 【Python】第一弹---解锁编程新世界:深入理解计算机基础与Python入门指南

- 华为OD机试E卷 --第k个排列 --24年OD统一考试(Java & JS & Python & C & C++)

- Python已安装包在import时报错未找到的解决方法

- 【Python】自动化神器PyAutoGUI —告别手动操作,一键模拟鼠标键盘,玩转微信及各种软件自动化

- Pycharm连接SQL Sever(详细教程)

- Python编程练习题及解析(49题)

点击排行

- 版本匹配指南:Numpy版本和Python版本的对应关系

- 版本匹配指南:PyTorch版本、torchvision 版本和Python版本的对应关系

- Python 可视化 web 神器:streamlit、Gradio、dash、nicegui;低代码 Python Web 框架:PyWebIO

- 相关性分析——Pearson相关系数+热力图(附data和Python完整代码)

- Anaconda版本和Python版本对应关系(持续更新...)

- Python与PyTorch的版本对应

- Windows上安装 Python 环境并配置环境变量 (超详细教程)

- Python pyinstaller打包exe最完整教程